Siguiente: Principio de máxima entropía Subir: Teoría de información Anterior: Teoría de información

Para avanzar con nuestra descripción, introduzcamos el operador

![]() , donde

, donde ![]() es una constante. El valor

medio de este operador en un ensamble es

es una constante. El valor

medio de este operador en un ensamble es

En el caso de tener un ensamble puro, en esta representación todos los

elementos de ![]() se anulan excepto uno que vale 1, de modo que

se anulan excepto uno que vale 1, de modo que

![]() . En otras palabras, cuando poseemos la máxima información sobre el

sistema,

. En otras palabras, cuando poseemos la máxima información sobre el

sistema, ![]() alcanza su valor mínimo. Por otro lado, en la próxima sección

veremos que

alcanza su valor mínimo. Por otro lado, en la próxima sección

veremos que ![]() alcanza el valor máximo cuando todas las probabilidades

alcanza el valor máximo cuando todas las probabilidades

![]() son iguales, es decir, cuando poseemos el mínimo de información

sobre el estado de un sistema.

son iguales, es decir, cuando poseemos el mínimo de información

sobre el estado de un sistema.

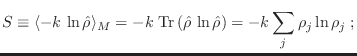

El valor de ![]() cuantifica de alguna manera la falta de información o la

incertidumbre respecto de un sistema. Esta magnitud se denomina entropía de información o entropía estadística2, y en general

para un sistema regido por una distribución de probabilidades

cuantifica de alguna manera la falta de información o la

incertidumbre respecto de un sistema. Esta magnitud se denomina entropía de información o entropía estadística2, y en general

para un sistema regido por una distribución de probabilidades ![]() se

define directamente como

se

define directamente como

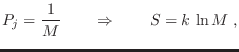

Si los ![]() estados accesibles para el sistema son equiprobables,

estados accesibles para el sistema son equiprobables,

En el caso de trabajar con variables continuas el desarrollo anterior se mantiene, excepto por el correspondiente reemplazo de sumatorias por integrales.

Gustavo Castellano 19/11/2021